销售数据分析是企业决策的关键支撑,而数据处理作为分析的基础环节,其质量直接决定了后续洞察的准确性与价值。一套系统、规范的数据处理流程能有效提升分析效率与可靠性。本文将围绕“五步法”,详细拆解如何为一份优质的销售数据分析做好数据处理工作。

第一步:明确目标与范围定义

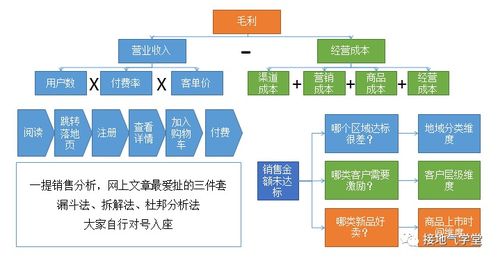

在接触任何数据之前,首先要明确本次分析的核心业务目标。是评估整体销售业绩、分析区域市场表现、追踪新产品上市效果,还是优化销售渠道结构?目标决定了需要收集哪些数据、数据的时间跨度(如季度、年度)、以及分析的维度(如产品线、客户群、销售团队)。清晰的定义能避免数据收集的盲目性,确保后续处理工作始终围绕核心问题展开。

第二步:多源数据收集与整合

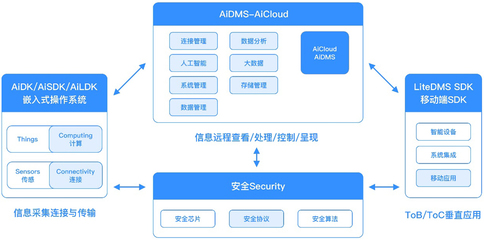

销售数据通常散落在多个系统中,如CRM(客户关系管理)、ERP(企业资源计划)、财务系统、电商后台、市场活动平台等。此步骤的关键在于:

- 识别数据源:根据第一步定义的范围,列出所有相关数据源。

- 提取核心字段:通常包括交易数据(订单ID、日期、产品、数量、金额、客户信息)、客户数据( demographics)、产品数据(类别、成本)、以及相关的市场与渠道数据。

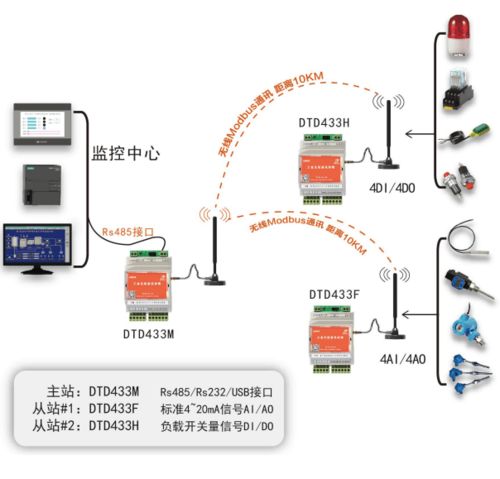

- 建立关联键:确保不同来源的数据能通过唯一标识符(如订单ID、客户ID、产品SKU)进行准确关联与合并,形成一个初步的、宽表形式的统一数据集。

第三步:数据清洗与质量校验

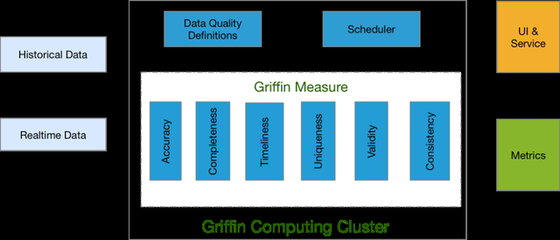

这是数据处理中最关键也最耗时的一步,旨在解决原始数据中的“脏数据”问题,确保数据的一致性与准确性。主要工作包括:

- 处理缺失值:识别关键字段(如金额、客户地区)的缺失,根据业务逻辑决定是删除、填充(如用均值、中位数、或基于其他字段推算)还是标记。

- 纠正错误值:检查并修正明显的异常值(如负的销售额)、格式不一致(如日期格式混杂)、拼写错误(如客户名称或产品类别)。

- 统一标准:确保相同含义的字段在不同数据源中格式一致(如将“华北”、“North China”统一为“华北区”)。

- 去重与验证:删除完全重复的记录,并验证业务逻辑(如同一订单的总金额是否等于各产品金额之和)。

通过此步骤,获得一个“干净”、可靠的数据基础。

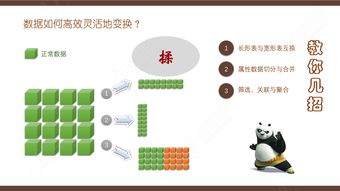

第四步:数据转换与特征工程

在清洗后的数据基础上,通过计算和转换,创建对分析更有直接意义的衍生字段(特征),以揭示更深层次的洞察。常见的转换包括:

- 计算衍生指标:如客单价、毛利率、环比/同比增长率、累计销售额、客户购买频次等。

- 数据分组与分类:将连续数据分箱(如将客户按消费金额分为高、中、低价值),或根据业务规则创建新的分类标签。

- 时间序列处理:生成年、季度、月、周等时间维度字段,便于趋势分析。

- 数据规范化/标准化:如需进行模型分析,可能需要对数值型数据进行尺度调整。

这一步是为分析“赋能”,将原始数据转化为富含信息的分析单元。

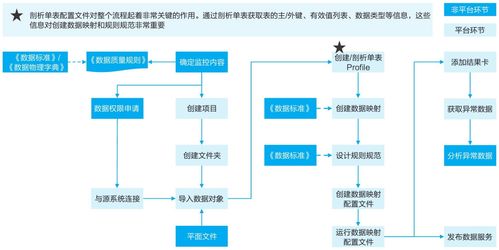

第五步:数据整合与结构化存储

将经过清洗和转换的最终数据集,以适合分析的形式进行组织和存储。

- 构建分析数据集:根据分析主题,可能形成事实表与维度表关联的星型/雪花型模型,或直接输出为一张包含所有必要字段的扁平化宽表。

- 选择存储格式:根据分析工具(如Excel、Power BI、Tableau、Python/R)选择合适的格式(如.csv、.xlsx、数据库表)。

- 文档化:记录数据处理的全过程,包括数据源、清洗规则、转换逻辑、字段定义等。这份数据字典或处理日志对于保证分析的可复现性、可审计性至关重要。

****

遵循以上五步法——从目标定义、收集整合、清洗校验、转换赋能到最终整合存储——能够建立起一个稳健、可重复的数据处理流水线。高质量的数据处理如同为大厦打下坚实的地基,它不仅为后续的数据可视化、建模分析与报告解读提供了可靠保障,更能让数据真正驱动销售策略的优化与业务增长。记住,在数据分析中,投入在数据处理上的时间,最终都会在洞察的准确性和决策的有效性上得到回报。