在信息爆炸的时代,我们常常会使用记事本记录各种信息,如日志、笔记、临时数据等。这些记事本文件通常包含结构化和非结构化的文本数据。对这些“带文字的记事本”进行数据分析,可以有效提取有价值的信息,为决策提供支持。由于记事本数据往往格式松散、缺乏统一结构,其数据处理过程需要特定的方法和技巧。本文将介绍如何系统地对记事本数据进行数据处理与分析。

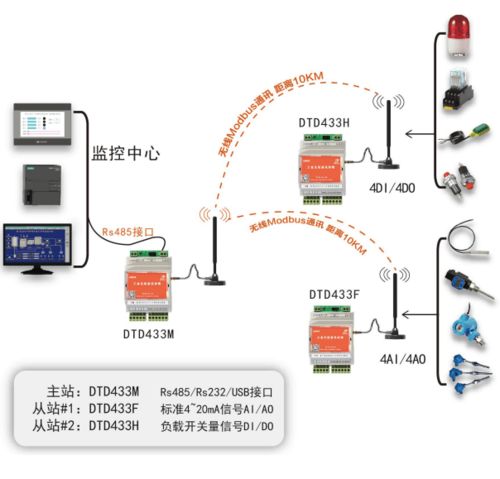

1. 数据采集与导入

数据处理的第一步是采集原始记事本文件。这些文件可能以.txt、.log、.csv(但以文本格式存储)等格式存在。在导入数据时,需要注意文件的编码格式(如UTF-8、GBK等),避免乱码问题。可以使用Python的open()函数、Pandas库的read_csv()(指定分隔符)或专门处理文本的工具进行读取。对于大量文件,可以编写脚本批量导入。

2. 数据清洗与预处理

记事本数据通常包含大量噪声,清洗是关键步骤:

- 去除无关内容:删除空白行、广告文本、重复条目等。

- 标准化格式:统一日期、时间、数字的格式,例如将“2023-1-1”转换为“2023-01-01”。

- 处理缺失值:识别并填充或删除缺失的数据字段。

- 文本清理:使用正则表达式去除特殊字符、标点符号,或进行分词处理(针对中文可用jieba库)。

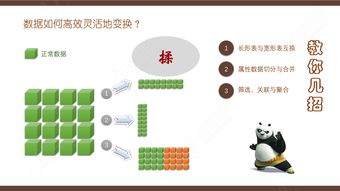

3. 数据结构化

记事本数据常为非结构化文本,需要转换为结构化数据以便分析:

- 定义字段:根据内容识别关键字段,如时间、地点、人物、事件等。

- 使用分隔符:如果数据中有固定分隔符(如逗号、制表符),可将其转换为表格形式。

- 自然语言处理(NLP):对于自由文本,应用NLP技术(如命名实体识别、情感分析)提取结构化信息。例如,从日志中提取错误类型和发生时间。

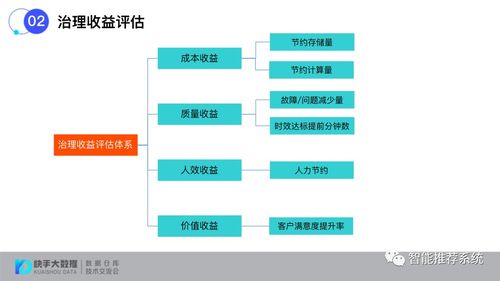

4. 数据分析与挖掘

一旦数据被结构化,即可进行深入分析:

- 描述性分析:统计词频、时间分布、关键指标汇总等。例如,分析记事本中特定关键词的出现频率。

- 趋势分析:识别数据随时间的变化模式,如用户活动高峰时段。

- 关联分析:发现不同字段之间的关系,比如某些事件常同时发生。

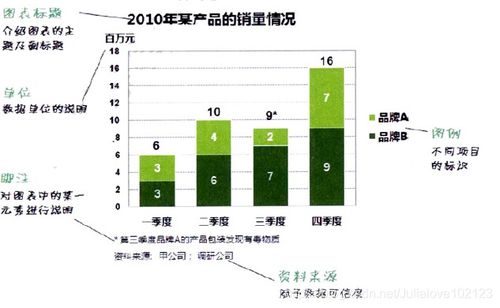

- 可视化:使用图表(如折线图、柱状图、词云)直观展示分析结果,帮助快速洞察。

5. 工具与实例

常用工具包括Python(Pandas、NumPy、正则表达式)、R、Excel以及文本编辑器(如Notepad++)。例如,一个简单的Python脚本可以自动化清洗日志文件:读取文件、过滤错误行、提取时间戳和错误码,并生成统计报告。通过结合这些工具,即使是杂乱的记事本数据也能转化为清晰的见解。

处理带文字的记事本数据是一个从混沌到有序的过程。通过系统的采集、清洗、结构化和分析,我们可以将这些日常记录转化为有价值的信息资产,助力个人或企业优化流程、发现问题并提升效率。随着人工智能技术的发展,未来这类数据处理将更加智能化和自动化。